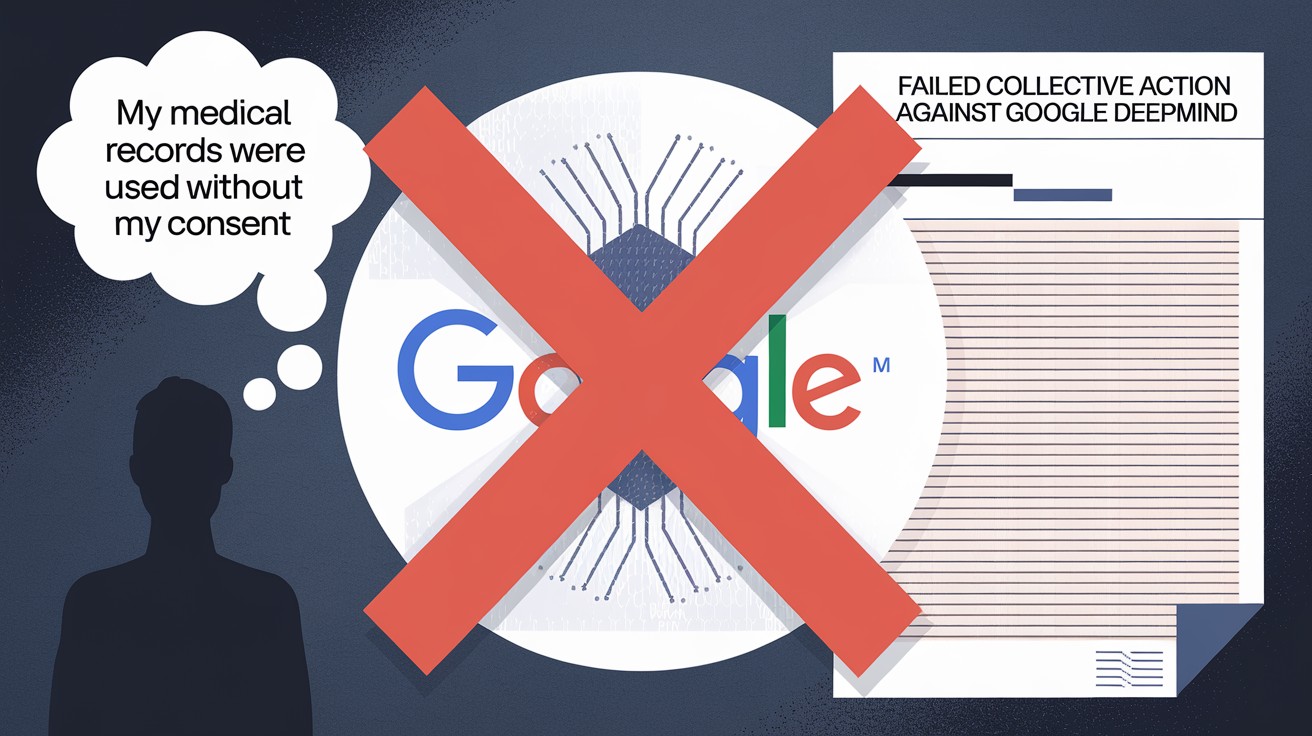

DeepMind échoue à relancer une action collective britannique en dommages et intérêts pour atteinte à la vie privée

La bataille juridique autour de l'utilisation controversée de données médicales par l'unité d'intelligence artificielle de Google, DeepMind, vient de connaître un nouveau rebondissement. Mercredi, la Cour d'appel du Royaume-Uni a rejeté une tentative de relancer une action collective en dommages et intérêts pour atteinte à la vie privée contre le géant technologique, soulignant les défis persistants des litiges liés à la confidentialité à l'ère du numérique.

DeepMind au cœur de la polémique sur les données de santé

L'affaire remonte à 2015, lorsque la filiale IA de Google a mis la main sur les dossiers médicaux de 1,6 million de patients du NHS, le système de santé public britannique, dans le cadre du développement d'une application mobile. Cette entente de partage de données entre DeepMind et le Royal Free London NHS Foundation Trust a par la suite été jugée illégale au regard de la législation britannique sur la protection des données, mais les dommages subis n'ont été que d'ordre réputationnel.

Un recours collectif avorté

En 2018, une plainte collective a été déposée au nom des patients concernés, réclamant des dommages et intérêts pour l'utilisation abusive de leurs informations confidentielles. Mais le recours a été rejeté en première instance, le juge estimant que les plaignants ne formaient pas un groupe suffisamment homogène au regard de la loi.

Les avocats des demandeurs ont fait appel de cette décision, arguant que l'affaire soulevait d'importantes questions de principe sur la protection de la vie privée et le droit à réparation. Ils espéraient faire jurisprudence et ouvrir la voie à d'autres actions collectives du même type.

La Cour d'appel confirme les obstacles aux recours collectifs

Mais dans son jugement rendu mercredi, la Cour d'appel a confirmé le rejet de l'action, pointant les difficultés persistantes à faire aboutir des recours collectifs pour atteinte à la vie privée. Les juges ont souligné que les plaignants n'avaient pas réussi à démontrer qu'ils avaient le même intérêt à agir, une condition sine qua non pour une action représentative.

Les difficultés d'intenter une action représentative pour utilisation abusive d'informations privées n'ont, une fois de plus, pas été surmontées.

Extrait du jugement de la Cour d'appel

La Cour a rappelé un précédent jugement dans une affaire similaire (Lloyd v. Google), qui avait également échoué sur cette question du même intérêt à agir des membres du groupe représenté.

L'économie des litiges sur la vie privée remise en cause

Pour que les recours en dommages et intérêts pour atteinte à la vie privée soient économiquement viables, il faut en effet pouvoir mutualiser de nombreuses plaintes individuelles. Mais à l'heure des réseaux sociaux, où les individus partagent volontairement quantité d'informations personnelles en ligne, il devient de plus en plus difficile de démontrer un préjudice commun.

Cette décision souligne le fossé qui se creuse entre les principes théoriques de protection des données et la réalité des pratiques numériques. Si la loi reconnaît la valeur de la confidentialité, la monétiser devient un véritable casse-tête juridique.

Vers une responsabilité éthique des acteurs de l'IA ?

Au-delà des questions de réparation, ce jugement relance le débat sur la responsabilité éthique des entreprises technologiques dans la collecte et l'exploitation des données personnelles. Dans le cas de DeepMind, malgré un cadre légal strict, le partage contestable de données médicales n'aura finalement eu que peu de conséquences.

Face aux limites du droit, certains appellent à un engagement volontaire des acteurs de l'intelligence artificielle en faveur d'une utilisation responsable et transparente des données. Des chartes éthiques aux audits d'impact, les pistes sont nombreuses pour restaurer la confiance. Mais sans garanties juridiques solides, le chemin sera encore long.